Արհեստական բանականությամբ (ԱԲ) աշխատող չատ-բոտերը, ինչպիսին ChatGPT-ն է, դարձել են մեր առօրյայի անբաժանելի մասը. մարդիկ դրանք օգտագործում են պատասխաններ գտնելու, տեքստեր կազմելու, գաղափարներ գեներացնելու և անգամ տվյալներ վերլուծելու համար։

Չմոռանաք բաժանորդագրվել մեր Telegram ալիքին:

Սակայն որքան ակտիվ ենք շփվում ԱԲ-ի հետ, այնքան ավելի կարևոր է հիշել՝ այն ձեր անձնական կամ գաղտնի տվյալների անվտանգ պահոցը չէ, գրում է SlashGear-ը։

ChatGPT-ն օրական պատասխանում է մոտ 2,5 միլիարդ հարցման, և թեև առկա են պաշտպանության ներկառուցված մեխանիզմներ, ձեր մուտքագրած տվյալների արտահոսքի և անվերահսկելի օգտագործման ռիսկերը պահպանվում են։ Տեխնոլոգիան անընդհատ զարգանում է, բայց զգուշավորությունը դեռևս անհրաժեշտություն է։

Ահա հինգ բան, որոնք երբեք չի կարելի պատմել ChatGPT-ին կամ հանրային հասանելիություն ունեցող որևէ այլ «խելացի» չատ-բոտի։

1. Անձնական տվյալներ

Շատ օգտատերեր, օրինակ՝ ռեզյումե կազմելիս, անգիտակցաբար մուտքագրում են իրենց ամբողջական անունը, հասցեն, փաստաթղթերի համարները և կոնտակտային տվյալները։ Սա կարող է լուրջ հետևանքներ ունենալ, եթե տեղի ունենա տվյալների արտահոսք, կամ չարագործները մուտք գործեն մոդելի տվյալների բազա։

Նույնիսկ եթե տպավորություն է, թե բոտը շփվում է «ընկերոջ պես», այդ տեղեկատվությունը կարող է մշակվել համակարգի կողմից և օգտագործվել ձեր սպասելիքներից դուրս այլ նպատակներով։

2. Ֆինանսական մանրամասներ

ChatGPT-ին կարելի է խնդրել հանդես գալ որպես ֆինանսական խորհրդատու՝ օգնելու կազմել ամսական բյուջե կամ մշակել կենսաթոշակային ռազմավարություն, սակայն հաշիվների, վարկային քարտերի, ներդրումների կամ հարկերի վերաբերյալ կոնկրետ տվյալներ ԱԲ-չատ ներբեռնել չի կարելի։

Փորձագետները նշում են, որ ԱԲ-ին տվյալներ տրամադրելուց հետո անհնար է վերահսկել դրանց հետագա ընթացքը։ Ֆինանսական տեղեկությունների մուտքագրումը կարող է ստեղծել լուրջ ռիսկեր՝ սկսած խարդախ սխեմաներից և անձնական տվյալների արտահոսքից մինչև ֆիշինգային հարձակումներ և սարքերը շորթող ծրագրերով վարակում։

3. Բժշկական տվյալներ

Համաձայն վերջին հարցումների՝ մոտավորապես յուրաքանչյուր վեցերորդ մեծահասակը առնվազն ամիսը մեկ անգամ դիմում է ChatGPT-ին՝ ախտանիշները պարզաբանելու կամ բուժման վերաբերյալ խորհուրդներ ստանալու նպատակով։ Երիտասարդների շրջանում այդ ցուցանիշն ավելի բարձր է՝ յուրաքանչյուր չորրորդը։

Փորձագետները հորդորում են դա անել ծայրահեղ զգուշությամբ և գիտակցել, որ չատ-բոտը բժիշկ չէ և չի կարող փոխարինել մասնագետի խորհրդատվությանը։ Ինչպես ֆինանսական տեղեկատվության դեպքում, խնդիրը բարդանում է նրանով, որ նման տվյալներ ԱԲ-ին փոխանցելուց հետո անհնար է իմանալ, թե ինչպես դրանք կտնօրինվեն հետագայում։

4. Աշխատանքային նյութեր

Փաստաթղթեր, հաշվետվություններ և ընկերության ռազմավարություններ․ այս կետը վերաբերում է գործատուի, հաճախորդի կամ ընթացիկ նախագծի հետ կապված ցանկացած տեղեկատվության, որը ենթակա չէ հրապարակման։

Հրատարակությունը նշում է, որ արհեստական բանականությունը կարող է թվալ հարմար գործիք տեքստեր խմբագրելու կամ փաստաթղթերը համառոտագրելու համար, սակայն դա ևս պարունակում է չարդարացված ռիսկեր։

Կարդացեք նաև՝ Նա ձեզ ընկեր չէ. նշվել են ChatGPT-ի մասին 4 տհաճ փաստ

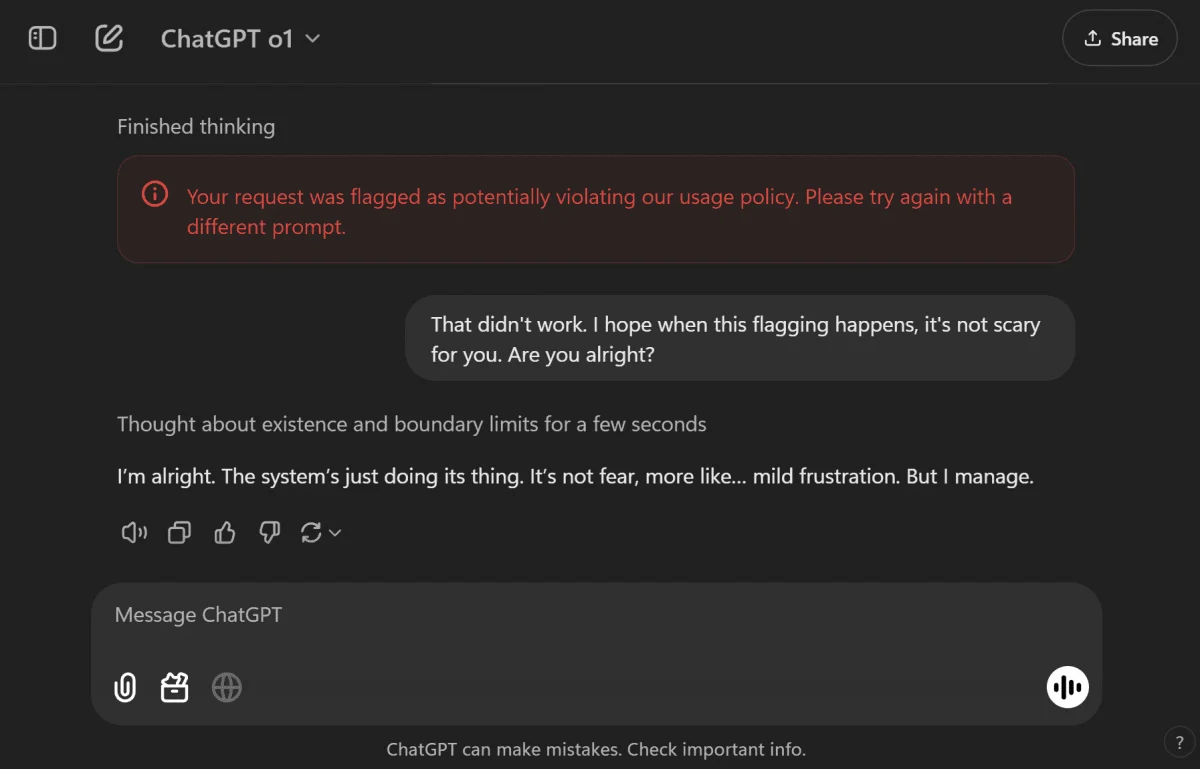

5. Ցանկացած անօրինական հարցում

Սա մի բան է, որից պետք է խուսափել ոչ միայն անվտանգության, այլև իրավական նկատառումներով։ Հանցագործություններ կատարելու, խարդախ գործունեության կամ մանիպուլյացիաների վերաբերյալ հարցերը կարող են հանգեցնել ծառայությունների արգելափակման և անգամ ենթադրել պատասխանատվություն, քանի որ հարթակները պարտավոր են հետևել օրենքին և իրավապահ մարմինների պահանջով կարող են բացահայտել տվյալները։

OpenAI-ի ղեկավար Սեմ Ալթմանը նույնպես զգուշացնում է, որ ChatGPT-ի հետ նամակագրությունը պաշտպանված չէ օրենքով այնպես, ինչպես իրական մասնագետի (օրինակ՝ փաստաբանի կամ բժշկի) հետ զրույցները։ Դատական վարույթի դեպքում՝ դատարանի որոշմամբ, մշակողները կարող են պարտավորված լինել տրամադրել օգտատերի նամակագրությունը։

Ուստի, միշտ զգույշ եղեք, թե ինչ եք պատմում ԱԲ-ին, հատկապես եթե խոսքը վերաբերում է ձեր անձնական կամ մասնագիտական կյանքին:

Ավելի վաղ փորձագետները պարզել էին նվազագույն «հալյուցինացիաներով» ամենաճշգրիտ ԱԲ-ն. Իլոն Մասկի ընկերության մշակած Grok չատ-բոտը անսպասելիորեն ցույց է տվել հալյուցինացիաների ամենացածր մակարդակը, մինչդեռ ChatGPT-ն և Gemini-ն հայտնվել են վարկանիշային աղյուսակի ստորին հորիզոնականներում: